近日,国际语音技术领域顶级盛会,同时也是全球最大的信号处理技术会议——2024年IEEE国际声学、语音和信号处理会议(2024 IEEE International Conference on Acoustics, Speech and Signal Processing, IEEE ICASSP 2024)在韩国首尔COEX国际展览中心举行。计算机学院“AI Lab智能语音/视频科研团队”雷震春副教授受邀出席本届大会,并面向来自全球4000多名与会学者宣讲团队最新的科研成果。

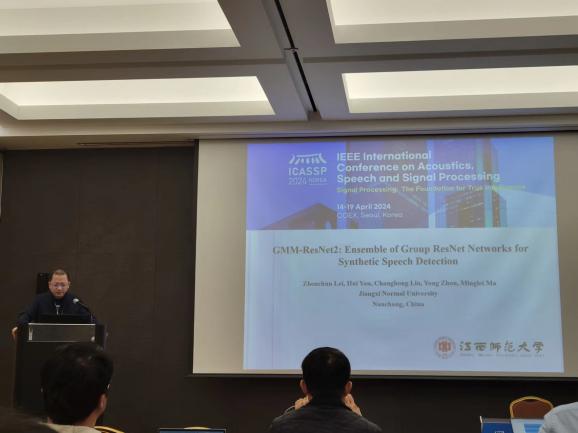

参会期间,雷震春副教授就“AI Lab智能语音/视频科研团队”两篇被ICASSP 2024录稿的论文“GMM-ResNet2: Ensemble of Group ResNet Networks for Synthetic Speech Detection”和“GMM-ResNext: Combining Generative and Discriminative Models for Speaker Verification”分别进行大会宣讲和海报展示。

在论文“GMM-ResNet2: Ensemble of Group ResNet Networks for Synthetic Speech Detection”中,课题组针对合成语音检测这一关键应用技术,在现有GMM-ResNet模型基础上,从多阶对数高斯概率特征融合、分组与集成、改进残差块、集成损失函数等四个关键技术进行改进,提出GMM-ResNet2模型用于合成语音检测,显著提升模型性能。

在论文“GMM-ResNext: Combining Generative and Discriminative Models for Speaker Verification”中,课题组针对说话人识别这一关键应用技术,提出将经典的生成模型GMM和目前流行的深度学习模型进行组合,显著提高说话人识别性能。

在雷震春副教授介绍论文的研究思路和研究结果期间,吸引了众多研究人员的驻足交流和讨论,得到国际同行的高度认可。雷震春副教授还和与会的全球学者介绍了“AI Lab智能语音/视频科研团队”未来研究方向和研究重点,极大地提升了团队的学术影响力。

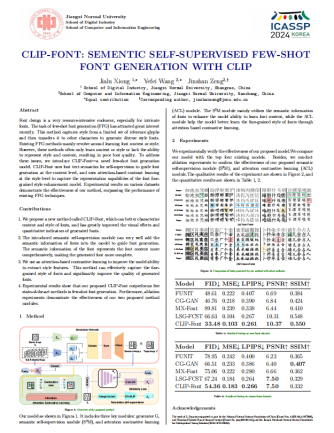

此外,计算机学院“AI创新应用科研团队”曾锦山教授课题组的两篇论文:“CLIP-Font: Sementic Self-Supervised Few-Shot Font Generation with Clip”和“CLIP-MSA: Incorporating Inter-Modal Dynamics and Common Knowledge to Multimodal Sentiment Analysis With Clip”,亦被ICASSP 2024录稿并进行海报展示。其中:第一篇论文的第一作者为曾锦山教授指导的研究生,第二篇论文的第一作者为学院青年教师黄琪博士,曾锦山教授为论文的通讯作者。在录用的两篇论文中,课题组针对现有小样本汉字生成和多模态情感分析中的瓶颈问题,分别利用CLIP的图文语义表示能力以及多模态特性来解决相应的瓶颈问题,提出了一种新颖的小样本字体生成模型和多模态情感分析模型,显著提升小样本字体生成和多模态情感分析性能。(文/图 计算机信息工程学院)